在当今的网络世界中,WordPress 多站点的 robots 配置成为了许多网站管理者关注的焦点,要想让多站点在搜索引擎中获得更好的表现,合理设置 robots 至关重要。

WordPress 多站点的 robots 并非难以捉摸,只要掌握了关键要点,就能轻松应对。

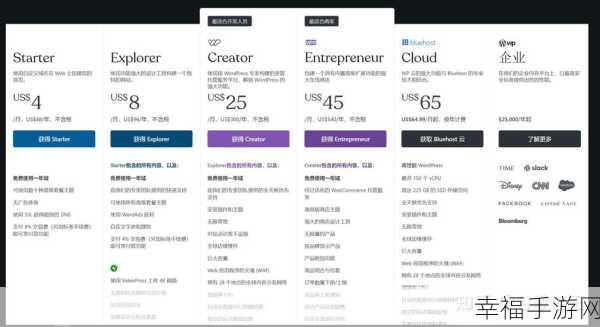

我们要明确 robots.txt 文件的作用,它是搜索引擎爬虫访问网站时遵循的规则说明,对于 WordPress 每个子站点可能有不同的需求,因此需要有针对性地进行配置。

了解常见的 robots 指令,User-agent”用于指定搜索引擎爬虫的类型,“Disallow”则用于禁止爬虫访问某些页面或目录。

根据站点的特点和目标来制定 robots 策略,如果某些页面还在建设中或者不希望被搜索引擎索引,就可以通过 robots.txt 进行限制。

在实际操作中,还需要注意一些细节,比如确保 robots.txt 文件的路径正确,以及及时更新和测试配置的有效性。

掌握好 WordPress 多站点的 robots 配置,能够为网站的优化和发展打下坚实的基础。

参考来源:相关技术论坛及官方文档

仅供参考,您可以根据实际需求进行调整和修改。